Der Vision Transformer ist ein Deep-Learning-Modell für Aufgaben der Objekterkennung und -segmentierung. Es verwendet Selbstaufmerksamkeitsmechanismen, um räumliche Beziehungen zwischen Pixeln zu analysieren, was ihm ermöglicht, groß angelegte Aufgaben effizient zu bewältigen.

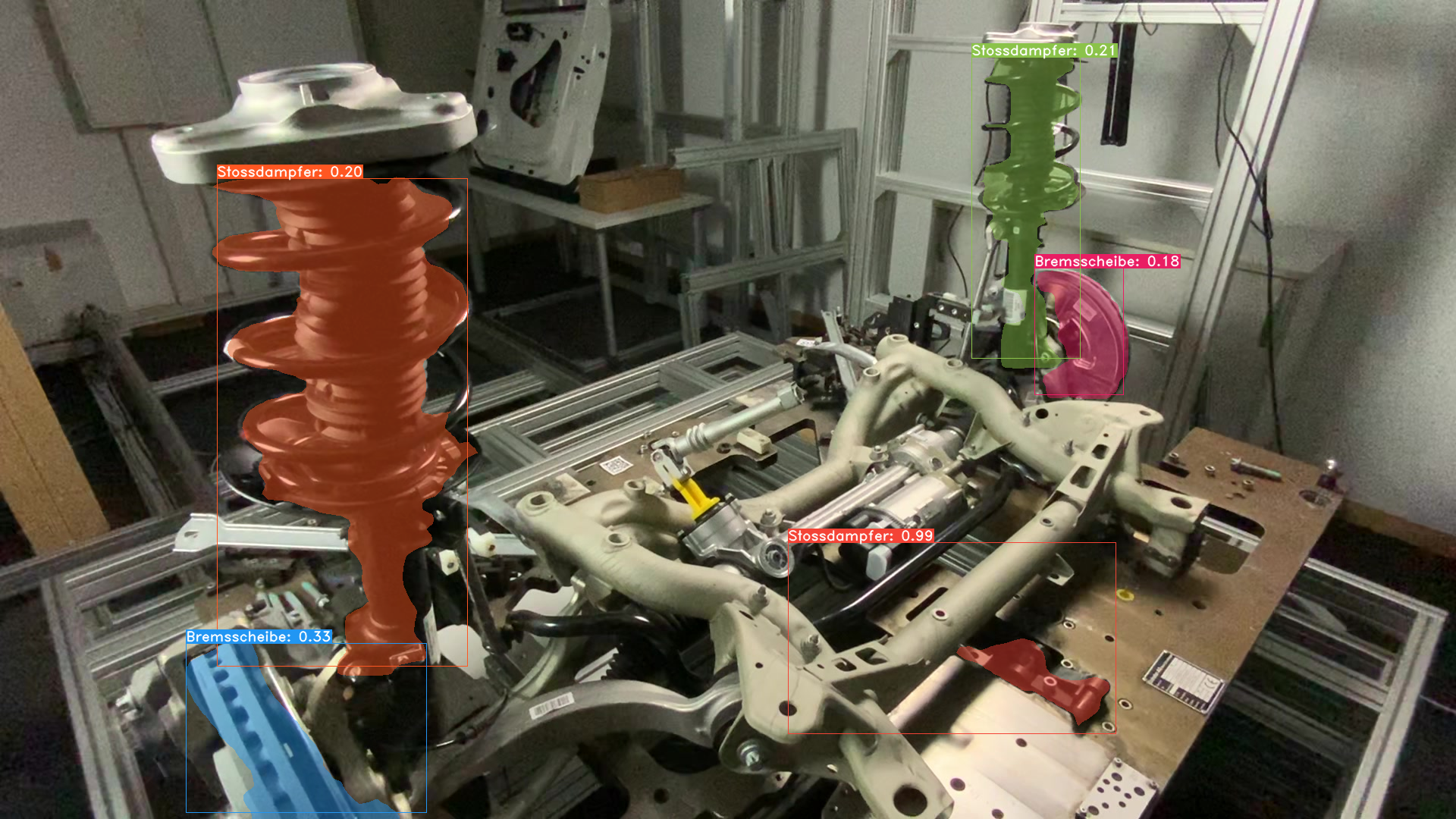

Zusätzlich ist der Vision Transformer in der Lage, hochgradige Merkmale aus Bildern zu lernen und zu extrahieren, was ihn gut für Aufgaben wie Objekterkennung und -klassifikation geeignet macht. Es gibt mehrere Varianten der Vision Transformer-Architektur, darunter die Modelle DETR (DEtection TRansformer) und SETR (SEgmentation TRansformer). Diese Modelle sind speziell für Aufgaben der Objekterkennung bzw. der Segmentierung entwickelt worden. Sie werden mit einer neuartigen Verlustfunktion namens Set-Prediction-Loss trainiert, die das Modell dazu anregt, die korrekten Objektsätze sowie die entsprechenden Begrenzungsrahmen oder Segmentierungs-Masken vorherzusagen.

Zusammenfassend lässt sich sagen, dass der Vision Transformer ein leistungsstarkes Deep-Learning-Modell ist, das gut für Aufgaben der Objekterkennung und -segmentierung geeignet ist. Seine Fähigkeit, Bilder parallel und effizient zu verarbeiten sowie hochgradige Merkmale zu lernen und zu extrahieren, macht ihn zu einem vielversprechenden Ansatz zur Lösung komplexer Computer-Vision-Probleme.

Fraunhofer-Institut für Graphische Datenverarbeitung IGD

Fraunhofer-Institut für Graphische Datenverarbeitung IGD